Die Qualität eines Gussteils beginnt bereits mit dem Rohstoffeinsatz für die Schmelze. Um die optimale Materialzusammenstellung zu finden, können mittels datenbasierter Verfahren die materialcharakteristischen und ofenspezifischen Wechselwirkungen modelliert werden. Die so ermittelte Auswahl der Eingangsmaterialien lässt sich dann nochmals bezogen auf Kosten- und Energieeffizienz optimieren. Im Sinne der Kreislaufwirtschaft können damit auch bereits verfügbare Rohstoffe effizient genutzt werden.

VON TIM KAUFMANN, KEMPTEN UND ANNIKA TONNIUS, DUISBURG

Die Anforderungen an die Produktion gegossener Bauteile sind in den letzten Jahrzehnten stetig gewachsen. Gleichzeitig erhalten Themen wie die Reduzierung von CO2-Emissionen und eine energieoptimierte Fertigung immer mehr Bedeutung. Umso wichtiger ist es für den Standort Deutschland, Trends zu erkennen und diese mit innovativen Ideen zu stützen, sodass die weltweite Vorreiterrolle in der Gießerei-Industrie bezogen auf Innovation, Forschung und Entwicklung erhalten bleibt.

Motivation

Eine besondere Herausforderung ist die Entwicklung und Implementierung von Industrie-4.0-Lösungen. Die Idee dahinter ist der Aufbau „intelligenter“ Gießereien, die sich durch ein zentralisiertes Produktionssystem auszeichnen, das Kundenaufträge, Lieferketten und Produktionsaktivitäten verwaltet, dokumentiert und möglichst noch gleichzeitig optimiert. Der Weg hin zu solchen „Smart Foundries“ ist nicht einfach; eine fundierte Digitalisierung der Prozesse ist vorzunehmen und aufgrund der anfallenden komplexen Daten müssen neue Analysemethoden adaptiert werden. Dies erfordert den Einsatz von bisher in der Gießerei-Industrie wenig genutzten Technologien wie „Künstlicher Intelligenz“. Etablierte Methoden wie die lineare Optimierung eignen sich aufgrund hardwareseitiger Entwicklungen immer mehr, um Entscheidungen zu unterstützen, die normalerweise allein auf „Augenmaß“ beruhen. Schlussendlich erfordert diese Weiterentwicklung Mitarbeiter, die die Möglichkeiten und Vorteile dieser Technologien verstehen und bereit sind, an diesem Innovationsgrad mitzuwirken.

Stand der Technik

In den letzten 20 Jahren wurden bereits signifikante Anwendungen von Künstlicher Intelligenz in der Gießerei-Industrie aufgezeigt. Bouhouche et al. zeigten, wie mithilfe der Anwendung künstlicher neuronaler Netze der Schmelzprozess in der Stahlindustrie, genauer gesagt die Prozessvariablen Gewicht der Zusatzstoffe (FeSi, FeMn, Koks) sowie die Schmelzetemperatur, optimiert gesteuert werden können [1]. In [2] wird ein „Neuro-Fuzzy“- Modell zur Verbesserung der Regelung der Endtemperatur im Elektro-Lichtbogenofen und die damit einhergehende Energieersparnis beschrieben. Karunakar und Datta entwickelten ein intelligentes System, das auf neuronalen Netzen mit Backpropagation basiert, mit dem Ziel, größere Gussfehler wie Risse, Kaltläufe oder Lunker vorherzusagen [3]. Ducic et al. präsentierten eine Methodik zur Optimierung des Anschnitt-Systems für den Sandguss unter Verwendung eines sogenannten genetischen Algorithmus (GA). Die Gültigkeit der optimierten Geometrie des Anschnitt-Systems wurde durch numerische Simulation mit der Gießerei-Software Magmasoft validiert [4]. In [5] wird ein adaptives „Neuro-Fuzzy“-Inferenzsystem (ANFIS) angewendet, um den Einfluss der Druckgussparameter auf die Porositätsbildung in AlSi9Cu3-Druckgusskomponenten zu untersuchen. Die Leichtmetallgießerei von BMW in Landshut nutzt nach eigener Darstellung bereits Business Intelligence, Predictive Analytics und künstliche Intelligenz, um ihre Gießprozesse in Echtzeit zu analysieren und zu optimieren [6]. In [7] wird durch maschinelles Lernen aufgezeigt, wie die Fließspannung von C15-Stahl sowie die mechanischen Eigenschaften von Gusseisen mit Kugelgrafit aus Prozessdaten prognostiziert werden können.

Auch Algorithmen der linearen Optimierung finden in der Gießereitechnik Anwendung, insbesondere im Bereich der Schmelze-Optimierung. Bereits 1989 bewiesen Hansen und Huge, dass durch ganzzahlige lineare Optimierung die minimalen Kosten von Gattierungen für Legierungen exakt bestimmt werden können [8]. Damals war die Berechnungszeit noch wesentlich länger und es konnten nur reduzierte Probleme in hinreichender Zeit gelöst werden. Ohno et al. Verwendeten lineare Optimierung für aus dem Recycling von Fahrzeugen gewonnenen Stahlschrott, der im Sinne der Ressourcenschonung zur Fertigung von Legierungen eingesetzt wurde [9].

Wie aus den oben genannten Beispielen ersichtlich ist, können datenbasierte Verfahren auf nahezu jeden Fertigungsprozess und jeden Werkstoff angewandt werden, sofern genügend fundierte Daten zur Modellierung eines Prozesses zur Verfügung stehen. Das Maschinelle Lernen (ML), ein Teilbereich der „Künstlichen Intelligenz“, hat gegenüber klassischen Methoden wie der statistischen Prozesskontrolle (z. B. lineare Regression) den Vorteil, dass auch Prozesse, die vielen Einflussgrößen und Wechselwirkungen unterliegen, analysiert werden können [10]. Sind in einem Entscheidungsprozess die Werte der Einflussgrößen bekannt oder durch maschinelles Lernen modelliert worden, bietet die lineare Optimierung die Möglichkeit, ein optimales Ergebnis hinsichtlich einer Zielgröße (z. B. Kosten) zu determinieren. Sowohl die Algorithmen des maschinellen Lernens als auch der linearen Optimierung liefern durch die stetige Weiterentwicklung von Computer-Hardware immer schneller präzise Ergebnisse, sodass ein Einsatz auch für mittelständische Unternehmen ohne große Rechenkapazität möglich ist.

Problembeschreibung

In der Regel müssen Schmelzen nach dem Gattieren und Einschmelzen mit Vorlegierungen (Primärrohstoffe wie FeMo, FeV, FeSi etc.) nachjustiert werden. Die Gründe sind vielfältig, liegen aber hauptsächlich in der unzureichenden chemischen Zusammensetzung der Rohstoffe sowie Faktoren wie dem Abbrand, der Oxidation von Legierungselementen und im Allgemeinen der Fahrweise des Schmelzaggregats. Im Anschluss erfolgen in der Stahlherstellung metallurgische Prozesse wie z.B. das Entschwefeln oder das Desoxidieren.

Um die Gattierung eines Induktionsofens zu planen, müssen also zum einen die chemische Analyse des zu schmelzenden Ziel-Werkstoffes mit den stofflichen Wechselwirkungen beim Schmelzen betrachtet werden, zum anderen ist der Bestand an verfügbaren Schrotten in die Berechnung mit einzubeziehen. Am Ende soll die Gattierung so zusammengestellt werden, dass eine bestimmte Zielgröße optimiert wird, zum Beispiel die kostenoptimale Zusammenstellung der verfügbaren Materialien oder die Minimierung des Energieeinsatzes.

Um die Gattierung eines Induktionsofens zu planen, müssen also zum einen die chemische Analyse des zu schmelzenden Ziel-Werkstoffes mit den stofflichen Wechselwirkungen beim Schmelzen betrachtet werden, zum anderen ist der Bestand an verfügbaren Schrotten in die Berechnung mit einzubeziehen. Am Ende soll die Gattierung so zusammengestellt werden, dass eine bestimmte Zielgröße optimiert wird, zum Beispiel die kostenoptimale Zusammenstellung der verfügbaren Materialien oder die Minimierung des Energieeinsatzes.

Vorgehensweise

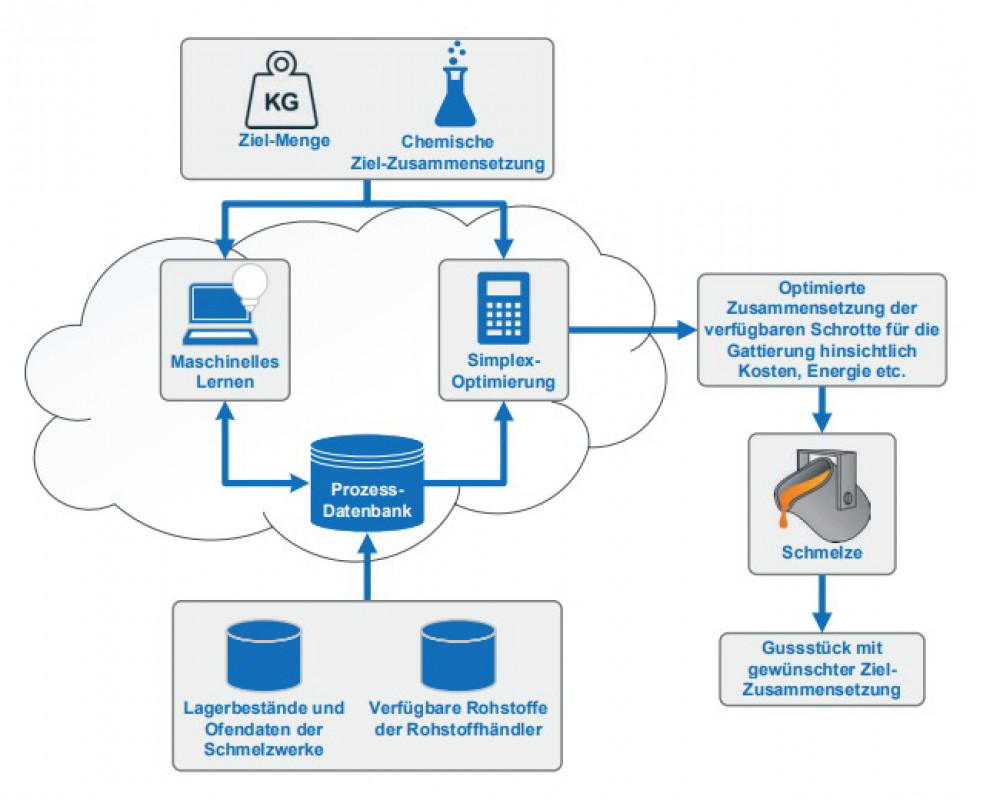

Bild 1 zeigt schematisch, wie das Maschinelle Lernen und die lineare Optimierung im Gattierungsprozess zum Einsatz kommen. Die rechenintensiven Algorithmen sollen in einer Cloud ausgeführt werden, sodass auch Firmen ohne große Rechenkapazitäten teilnehmen können. Zentrales Element ist eine Prozessdatenbank, an welche die für die Optimierung nötigen Daten der Schmelzwerke, wie eigene Lagerbestände oder Ofendaten, sowie die Lagerbestände teilnehmender Rohstoffhändler übergeben werden. Das ML-Tool nutzt diese Daten zur Aufstellung eines Modells, dessen Parameter wieder in die Prozessdatenbank geschrieben werden. Auf der anderen Seite greift ein (Simplex-)Algorithmus auf die Prozessdatenbank mit den neuen Parametern des ML-Modells zu, um basierend auf dem gewünschten Ziel-Material mit seiner chemischen Zusammensetzung und der Ziel-Menge eine Optimierung durchzuführen. Bei der Berechnung der nun kosten- und ressourcenoptimierten Zusammenstellung der Gattierung berücksichtigt die lineare Optimierung all diese Faktoren.

Wird die berechnete Materialzusammenstellung eingeschmolzen, ist nur eine geringe Justierung der Schmelze nötig, um die gewünschte Zielzusammensetzung zu erreichen.

Simplex-Optimierung

Grundlagen

Der Simplex-Algorithmus gehört zu den linearen Optimierungsalgorithmen. Mit ihm können Maximierungs- oder Minimierungsprobleme gelöst werden [11]. Im Fall der Gattierungszusammenstellung handelt es sich um ein Minimierungsproblem, da ein Zielwert wie Kosten oder Energieeinsatz minimal werden soll. In einer Zielfunktion wird der Zielwert definiert und mit den Variablen und Parametern in Beziehung gebracht, die Einfluss auf diesen haben.

Für die im Zuge des Forschungsprojekts erstellte Web-Anwendung wurde eine Implementierung des Simplex-Algorithmus in der Programmiersprache C# programmiert und in die Anwendung integriert. Da dabei keine externen Programmierbibliotheken genutzt wurden und der Code auf das beschriebene Problem der Gattierungsoptimierung abgestimmt wurde, werden Ergebnisse selbst bei mehr als 500 Lagerbeständen und ca. 100 Nebenbedingungen in weniger als einer Sekunde zurückgegeben. Der Nutzer übergibt der Anwendung über Auswahlfelder (z. B. Zielmenge) und Daten-Import (z. B. Lagerbestand) Informationen, die das Programm im Hintergrund in die benötigten Variablen und Gleichungen transformiert.

Beispiel

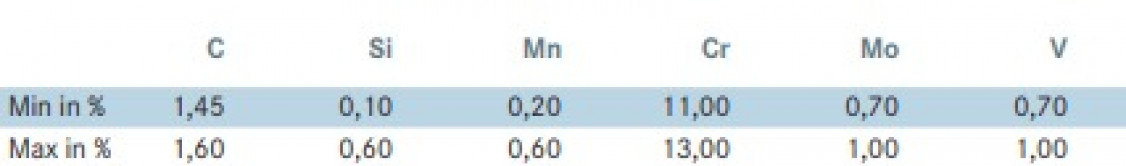

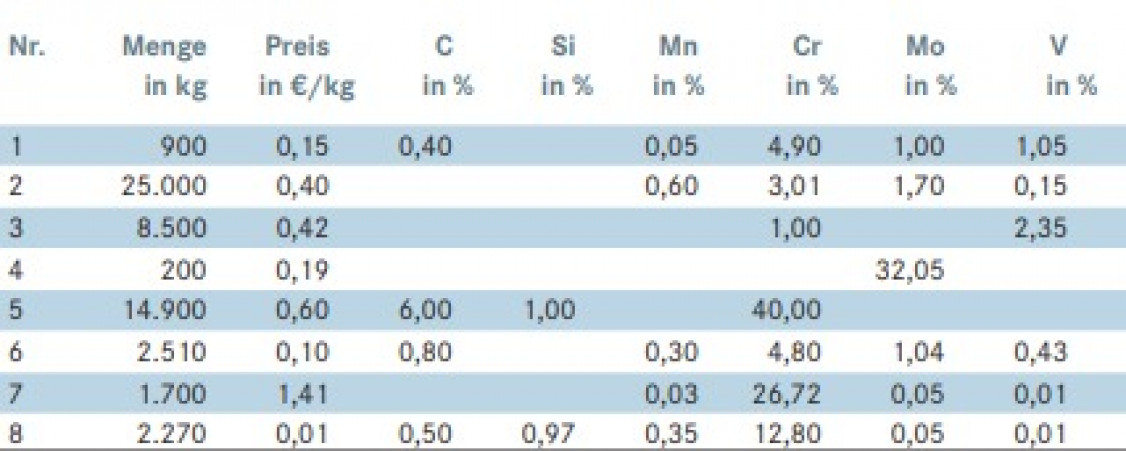

Es sollen 5000 kg des Werkstoffs 1.2379 geschmolzen werden. Zur Vereinfachung gehen wir davon aus, dass es keine stofflichen Wechselwirkungen gibt; nach dem Schmelzen entspricht die chemische Analyse des Werkstoffs also genau der Summe der chemischen Bestandteile der Materialien, die der Schmelze zugeführt wurden. Die Bestandteile des Werkstoffs entnehmen wir aus der entsprechenden DIN-Norm (Tabelle 1). Die chemische Analyse der Schmelze muss die aufgeführten Elemente im entsprechenden Bereich enthalten und beschreibt den Output des Modells. Tabelle 2 gibt einen Lagerbestand wieder, der acht Positionen umfasst. Jede Position stellt ein Material oder eine Charge Metall-Schrott dar, die für die Gattierung infrage kommen kann. Die Tabelle enthält also den Input für das Modell.

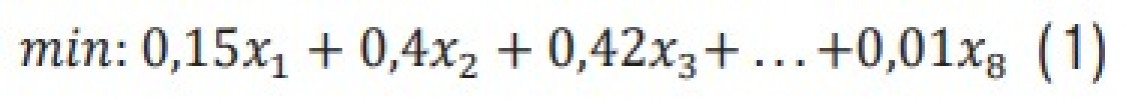

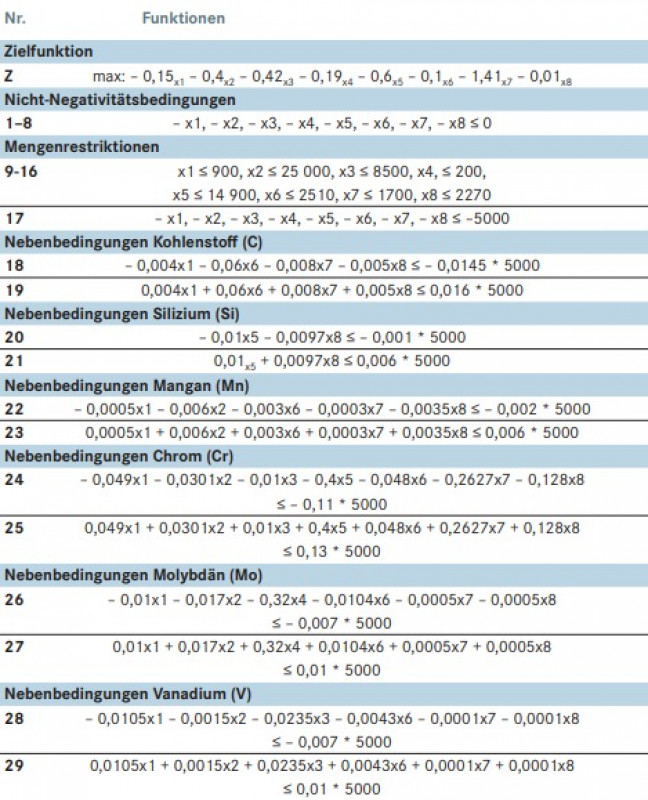

Damit sind alle Informationen vorhanden, um ein Modell für die Simplex-Optimierung aufzustellen. Zuerst wird die Zielfunktion gebildet, in diesem Fall die Kosten. Diese sind abhängig vom zugeführten Material, sowohl von der Menge als auch von den Kosten pro kg. Die Kosten sind bereits bekannt und unveränderbar (Tabelle 2, Spalte 3). Variabel sind die Mengen der einzelnen Lagerpositionen, die von der maximal verfügbaren Menge (Spalte 2) subtrahiert werden. Der Gesamtpreis ergibt sich aus der Summe der Materialkosten, multipliziert mit der Menge (Gleichung 1):

wobei xn für die gewählte Menge des Materials mit der Nummer n steht.

Um diese Zielfunktion minimieren zu können, müssen basierend auf der Zielmenge der chemischen Analyse des Lagerbestandes und des Zielmaterials Grenzen für unseren Lösungsraum definiert werden. So ist das Einfügen negativer Gewichtswerte noch möglich.

Wo ein Mensch diese Werte direkt als unsinnig identifizieren würde, muss dies einem Algorithmus explizit durch das Angeben von Nebenbedingungen vermittelt werden, die Grenzen darstellen, innerhalb derer sich ein Lösungsraum befindet. Es kann obere und untere Grenzen geben. Sobald in einer Lösungsmöglichkeit eine obere Grenze über- oder eine untere Grenze unterschritten wird, handelt es sich nicht mehr um eine zulässige Lösung. In diesem Beispiel sind alle Grenzen Geraden; wir behandeln folglich ein lineares Problem. Würde man alle diese Gerade aufzeichnen, ergäbe der Lösungsraum ein Polyeder in einem mehrdimensionalen Raum. Innerhalb dieser Grenzen hat der Simplex-Algorithmus die Fähigkeit, nach der optimalen Lösung zu suchen.

Die erste Nebenbedingung, die aufgestellt wird, ist die Nicht-Negativitätsbedingung (Gleichung 2)

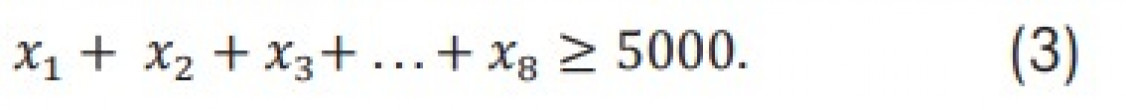

Durch sie werden negative Mengenangaben vermieden. Die Variablen können weiterhin null werden. Das ist zulässig, da nicht unbedingt jedes Material aus dem Lager für eine bestimmte Gattierung verwendet wird. Im Vergleich teure Materialien oder solche mit einer unpassenden Stoffzusammensetzung werden so nicht in die Ergebnisliste aufgenommen. Durch Gleichung 2 werden die Mengen nach unten begrenzt. Die oberen Grenzen bilden unsere maximal verfügbaren Lagerbestände der einzelnen Positionen (Tabelle 2, Spalte 2). Für Material 1 bedeutet dies: x1 ≤ 900 kg, für Material 2: x2 ≤ 25 000 kg usw. Um insgesamt die gewünschte Menge des Zielmaterials zu erreichen, wird Gleichung 3 benötigt:

Dass die kostengünstigsten Materialien, keine negativen Mengenangaben und 5000 kg in Summe ausgewählt werden, wird durch die ersten drei Bedingungen sichergestellt. Die chemische Zusammensetzung wurde bisher außer Acht gelassen. Jedes Element des Materials 1.2379 hat einen Minimal- und einen Maximalwert, welche für die Definitionen der unteren und oberen Grenzen beachtet werden müssen. Für jedes Material im Lagerbestand ist bekannt, ob es eines der Elemente enthält und zu welchem Anteil. Diese Angaben werden genutzt, um für jedes Element eine obere und untere Nebenbedingung festzulegen.

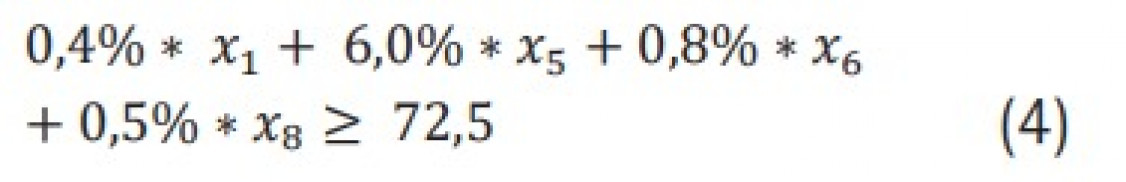

Der Stahl 1.2379 muss mindestens 1,45 % Kohlenstoff (C) enthalten; dies ergibt einen Gewichts-Anteil von mindestens 1,45 % * 5000 kg = 72,5 kg C in den Materialien, die der Schmelze zugeführt werden. Wie viel Kohlenstoff in einer Gattierung vorhanden ist, kann über die Menge der Materialien in der Schmelze und die jeweiligen Kohlenstoff-Anteile (Tabelle 2, Spalte 4) berechnet werden. Multipliziert mit den zu optimierenden Mengen (Variablen x1 bis x8) und summiert müssen sie mehr als 72,5 kg ergeben (Gleichung 4):

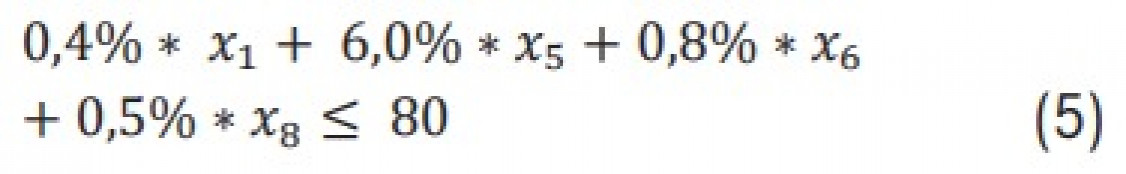

Gleichzeitig darf die Summe der Kohlenstoffanteile 1,6 % * 5000 kg = 80 kg nicht überschreiten. Als obere Schranke für C wird daher Gleichung 5 als Nebenbedingung definiert:

Das Erstellen einer unteren und einer oberen Nebenbedingung wird für alle relevanten Elemente wiederholt. Damit sind für das vereinfachte Beispiel alle Gleichungen aufgestellt.

Für den Simplex-Algorithmus müssen die Gleichungen noch umgestellt werden. In der Standardform behandelt der Simplex-Algorithmus ein Maximierungsproblem und alle Nebenbedingungen müssen in der Form „kleiner gleich“ aufgestellt werden. Alle oberen Grenzen müssen folglich in untere Grenzen umgewandelt werden, was durch eine Multiplikation der Gleichung mit dem Faktor „-1“ erreicht wird. In Tabelle 3 sind alle 29 Nebenbedingungen und die Zielfunktion in umgewandelter Form abgebildet. In dieser Form können die Gleichungen dem Simplex übergeben werden, welcher dann die Simplex-Schritte durch Matrix-Operationen ausführt, bis das optimale Ergebnis gefunden wurde. Dafür benötigt der Algorithmus zunächst eine zulässige Startlösung, von welcher ausgehend die Optimierung erfolgen kann. Kann keine Startlösung gefunden werden, kann das Problem auch nicht gelöst werden, vorausgesetzt das Modell wurde korrekt aufgestellt. Dies wäre zum Beispiel der Fall, wenn eine zu hohe Menge des Ziel-Werkstoffes verlangt wird, die nicht durch den Lagerbestand bedient werden kann.

Ergebnisdiskussion

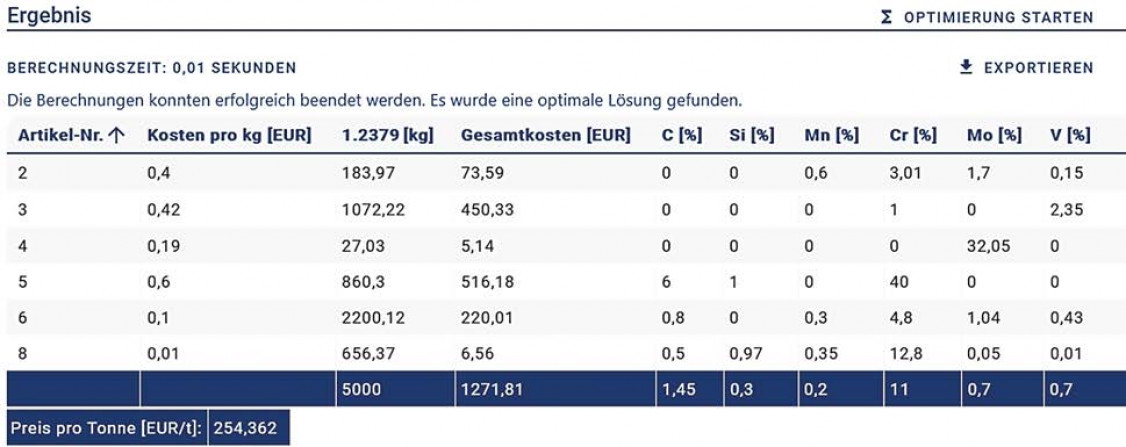

Bild 2 zeigt in einer verkürzten Version die Ausgabe des Ergebnisses des Simplex-Algorithmus aus der Web-Anwendung. Jedes Material, das laut Optimierung in der Gattierung vorkommen soll, ist aufgeführt. Zusätzlich zum bereits bekannten kg-Preis (Spalte 2) und der chemischen Analyse (Spalten 5-10) ist angegeben, wieviel kg der einzelnen Materialien hinzugefügt werden sollen (Spalte 3) und welche Kosten dies verursacht (Spalte 4). In der letzten Zeile werden die Preise und Mengen kumuliert. Die Optimierung liefert die gewünschte Menge von 5000 kg und gibt einen Preis von 1271,81 € aus. Zu den einzelnen Elementen ist angegeben, zu wie viel % sich diese in der Gesamtmenge befinden. So lässt sich leicht überprüfen, ob die Analyse der Gattierung den Vorgaben entspricht. Bei fast allen Materialien befindet sich der Anteil an der Minimalgrenze unserer Vorgaben. Lediglich Silizium ist zu einem größeren Anteil vorhanden (0,3 % statt 0,1%).

Zwei der acht Lagerbestände tauchen in der Gattierung nicht auf. Für den Bestand 7 gibt es die einfache Erklärung, dass dieser im Vergleich zu den anderen Beständen teuer ist. Material 1 ist zwar günstig, besitzt aber anteilig weniger Elemente, die für die Zielschmelze erforderlich sind. So kann der Bedarf an Chrom zu einem großen Teil von Material 6 gedeckt werden. Dieses ist zwar teurer, bietet aber pro kg mehr Chrom als andere Materialien und muss daher nicht in so großen Mengen hinzugefügt werden.

Auch wenn der Simplex-Algorithmus schnell Ergebnisse liefert, sind diese wenig aussagekräftig, wenn die Eingangsdaten das metallurgische Problem ungenau beschreiben. Deswegen ist eine Verknüpfung mit Methoden des maschinellen Lernens notwendig, um metallurgisches Wissen in die Daten zu integrieren und die Rohstoffausnutzung zu erhöhen.

Datengetriebene Prozessmodelle

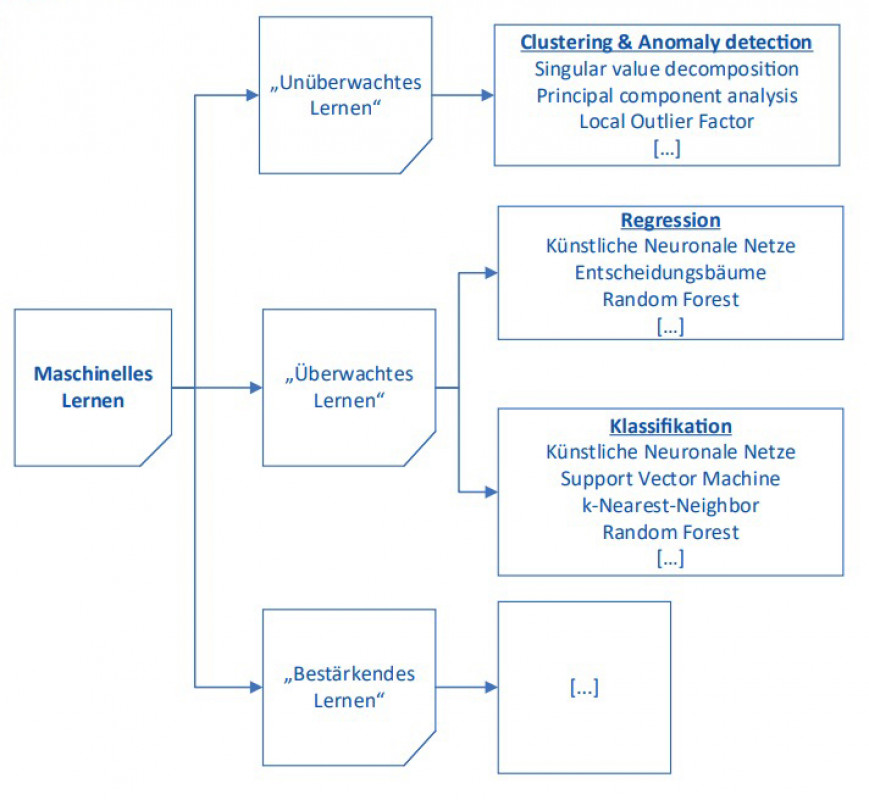

Künstliche Intelligenz wird oftmals in Kombination mit dem Begriff Industrie-4.0 verwendet. Dieser Teilbereich der Informatik umfasst viele unterschiedliche Methoden, die sich im Wesentlichen mit der Automatisierung intelligenten Verhaltens und dem sogenannten maschinellen Lernen (Machine Learning, ML) befassen. Mithilfe von ML können wissensbasierte Systeme, Musteranalysen, -erkennungen und -vorhersagen von Prozessen entwickelt werden [12]. Konkret bedeutet dies, einen Algorithmus mit vorhandenen Prozessdaten (Input- bzw. Trainingsdaten) anzulernen (Training), sodass dieser die Eigenschaften (z.B. physikalische oder chemische) und Wechselwirkungen des Prozesses „lernt“ und anhand dieser Prognosen über eine Zielgröße des Prozesses treffen kann. Auf die Trainingsphase folgt eine Testphase, in der dem gelernten Modell neue, unbekannte Daten zur Verfügung gestellt werden, anhand derer Prognosen über festgelegte Zielgrößen (Output) ermittelt werden sollen. Im Allgemeinen lässt sich maschinelles Lernen in drei Hauptgruppen einteilen (Bild 3):

> Unüberwachtes maschinellen Lernen: dem Algorithmus werden keine Beispieldaten mit definierten Zielgrößen zur Verfügung gestellt, sondern Daten, aus denen er eigenständig signifikante Gruppen und Muster in den Daten erkennen soll.

> Überwachtes Lernen: vom Anwender wird eine Zielgröße festgelegt und der Algorithmus trainiert. Das überwachte Lernen lässt sich weiter in Regression (z.B. Bauteil hat den konkreten Kohlenstoffgehalt oder die konkrete Streckgrenze; stetiger Wert) und Klassifikation einteilen, bei der die Zugehörigkeit zu einer Klasse vorhergesagt wird (z.B. Bauteil ist Ausschuss Ja / Nein). In der Regel lässt sich eine Regression auch per Diskretisierung in eine Klassifikation überführen. Viele Algorithmen, die auf Klassifikationsprobleme spezialisiert sind, können auch Regressionsprobleme modellieren und umgekehrt.

> Bestärkendes Lernen (Reinforcement Learning) ist eine besondere Form des maschinellen Lernens. Diese Algorithmen interagieren mit der Umwelt, werden durch ein Belohnungssystem bewertet und entwickeln so selbständig eine Problemlösung.

Zu jedem Bereich gibt es eine Vielzahl an Methoden und Algorithmen, wobei jeder einen anderen Ansatz beim Lernen verfolgt. Ein künstliches neuronales Netz lernt gänzlich anders als z. B. ein auf Entscheidungsbäumen basierendes System. Die richtige Auswahl ist nicht einfach und hängt von der Größe und Art der zu verwendenden Daten und den aus diesen Daten zu erzielenden Ergebnissen ab. ML im Allgemeinen hat ein breites Anwendungsspektrum [12] und ist in vielen Industriezweigen bereits zu einem wichtigen Optimierungswerkzeug geworden.

Schmelzprozess im Induktionsofen

Datenbasis

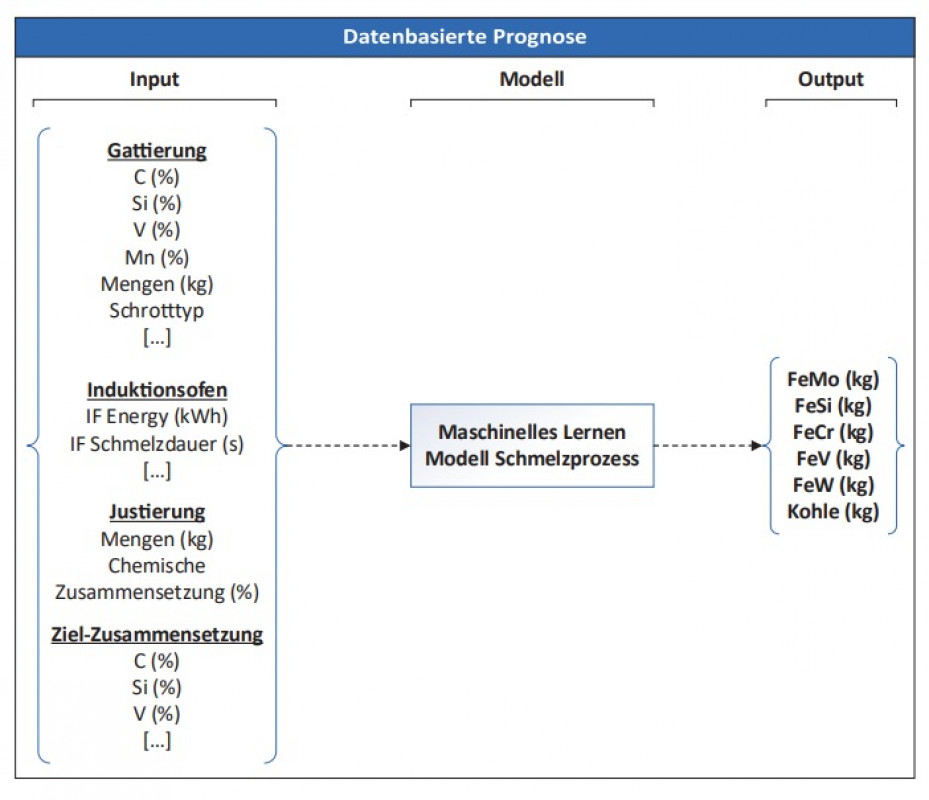

Um die gewünschte chemische Zusammensetzung sowie Zieltemperatur der Metallschmelze einzustellen, ist die Steuerung des Schmelzvorgangs zwingend erforderlich. Aufgrund der Wechselwirkungen zwischen Prozessparametern wie Wärmeverlust und Kinetik der thermodynamischen Reaktionen ist das Schmelzen von Stählen im Induktionsofen ein komplexer Prozess, der nur aufwendig mit klassischen Methoden wie z.B. einer thermodynamischen Simulationssoftware zu modellieren ist. Stellgrößen in diesem Prozess sind neben den gattierten Rohstoffen z.B. die Fahrweise des Ofens (Energieeintrag, Schmelzdauer etc.) oder die Menge der Zulegierung zur Justierung der chemischen Zusammensetzung. Im Zuge des hier vorgestellten Projektes soll untersucht werden, ob die Vorgänge im Induktionsofen mithilfe von maschinellem Lernen modelliert werden können (Datenbasierte Modelle). Ziel ist es, die Mengen an erforderlichen Vorlegierungen zur Justierung der Schmelze mithilfe eines Prognosemodells zu analysieren. Hierzu werden die Daten der Gattierung (chemische Analyse, Art des Schrottes …), die Parameter des Induktionsofens (Dauer Schmelzprozess, eingebrachte Energie, Temperaturführung …), die genutzten Vorlegierungen (Menge, Art, chemische Zusammensetzung …) sowie die gewünschte Zielzusammensetzung (in %) als Eingangsgrößen gewählt. Die Zielgrößen sind die Zugabemengen der Vorlegierungen, die zur Schmelzejustierung erforderlich sind.

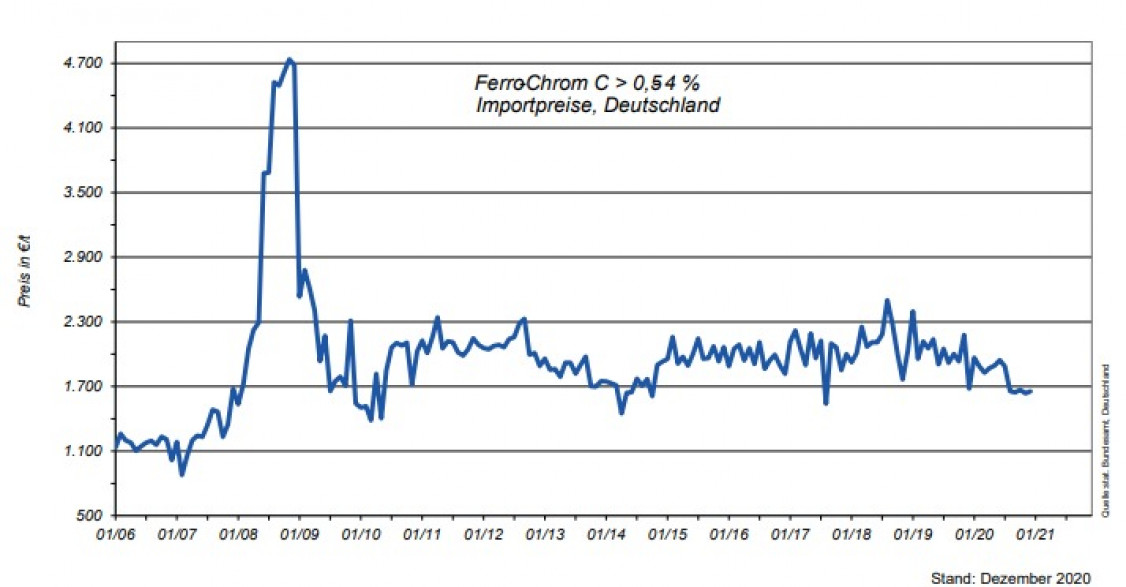

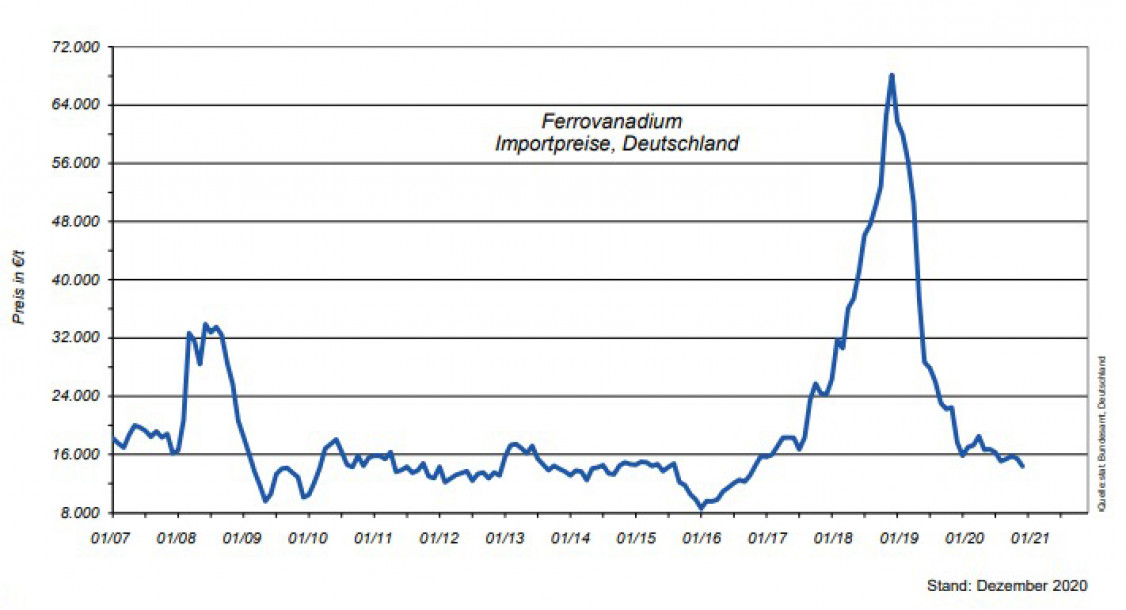

Die Datenerfassung wurde unter realen Bedingungen in einer Stahlgießerei durchgeführt. Das Schmelzaggregat ist ein Mittelfrequenz-Induktionsofen mit einer Kapazität von ca. 7 t. Das Schmelzen folgt hierbei dem typischen Produktionsprozess in einer Gießerei, d.h. nach dem Gattieren und Schmelzen erfolgen Qualitätskontrollen sowie metallurgische Behandlungen und ggf. eine Justierung der Schmelze. Die dafür genutzten Ferrolegierungen sind oftmals sehr teuer und unterliegen starken Preisschwankungen (Bilder 4 und 5). Ein Beispiel ist Ferrovanadium (FeV), das zur Herstellung von 1.3343 Schnellarbeitsstahl benötigt wird.

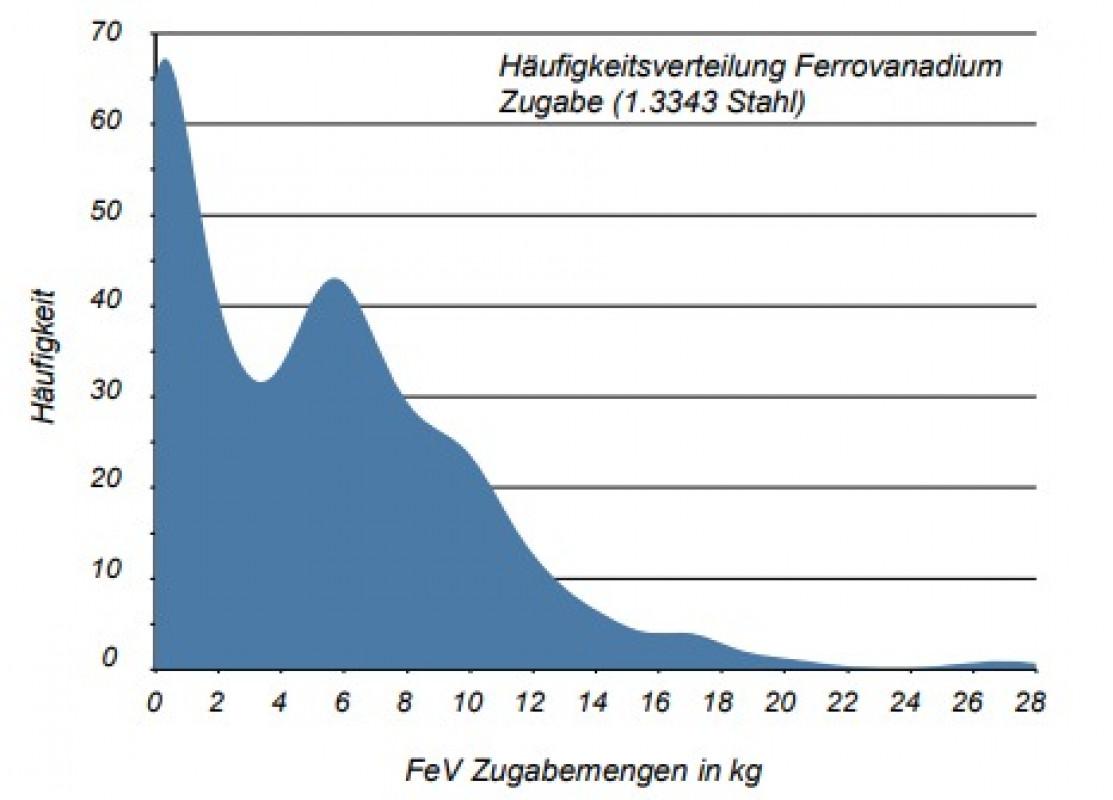

Der Preis lag zum Zeitpunkt der Recherche bei ca. 15-20 € / kg. Bild 6 zeigt exemplarisch die Verteilung der Zugabemengen für FeV zur Justierung einer 1.3343 Stahlschmelze. In diesem Datensatz mussten der Schmelze im Mittel 5 kg FeV hinzugegeben werden, um die Ziel-Zusammensetzung bezüglich des Vanadium-Gehalts zu erreichen. Die summierte Zugabemenge von reinem FeV betrug ca. 2 t.

Die grundsätzliche Idee dieser erstellten Prognosemodelle ist es zu eruieren, ob bestimmte Schrotte und Ofenfahrweisen zu erhöhten Ferrolegierungszugaben führen. Diese Information wird dann bereits bei der Schrottauswahl in Kombination mit dem Simplex-Algorithmus genutzt und bei der Fahrweise des Ofens berücksichtigt. Hierdurch soll der nötige Einsatz der Primärrohstoffe minimiert, d.h. die Häufigkeitsverteilungen des Einsatzes der Ferrolegierungen, ähnlich der Vanadium-Verteilung, zu niedrigen Mengen hin verschoben werden.

Modellstruktur und Algorithmen

Zur Erstellung des datenbasierten Prognosemodells wurden die Daten von insgesamt ca. 2300 Schmelzen der Stahlwerkstoffe 1.2379, 1.2343 und 1.3343 genutzt (Bild 7). Als Input wurden 58 verschiedene Prozessparameter berücksichtigt. Als Output soll das Modell die zur Einstellung der gewünschten Ziel-Zusammensetzung nötigen Mengen an Ferrolegierungen und Kohlenstoff vorhersagen.

Der erste Schritt einer Modellierung ist, den zugrundeliegenden Datensatz auf Ausreißer und Anomalien hin (Leerzellen, offensichtlich falsche Daten wie z.B. negative Mengenwerte …) zu untersuchen. Dies erfolgt mithilfe der modifizierten ZScore-Methode sowie dem sogenannten „Local-Outlier-Factor“-Algorithmus. Ca. 15 % der Daten wurden hierdurch als Ausreißer oder Datenungenauigkeiten identifiziert und entfernt. In der anschließenden Trainingsphase wird eine Aufteilung in Trainings- und Validierungsdaten durchgeführt. Anhand der Validierungsdaten schätzen die jeweiligen Algorithmen den aktuellen Prognosefehler ab und trainieren das Modell. Über diesen iterativen Prozess von Training und Validierung wird das Modell mit dem geringsten Prognosefehler entwickelt. In diesem Beispiel wird eine zehnfache Kreuzvalidierung genutzt. Die Testdaten werden komplett von den Trainingsdaten isoliert, was bedeutet, dass der zu trainierende Algorithmus diese Daten nicht kennt; sie dienen nur zur Begutachtung der Prognosegüte nach dem Training und simulieren daher neue, zukünftige Inputdaten.

Für die Modellerstellung werden die folgenden Algorithmen trainiert:

> Künstliche Neuronale Netze Regression(NN),

> Random-Forest-Regression (RF),

> k-Nearest-Neighbor Regression (k-NN),

> Support-Vector-Machine Regression (SVM),

> AdaBoost-Regression (AB),

> Stack.

NN, RF und k-NN sind klassische Algorithmen aus dem Bereich ML. Bei Ada-Boost und Stack handelt es sich um sogenannte Meta-Algorithmen, die keine eigenen Prognosen liefern, sondern die Prognosegüte von zwei oder mehr Basis-Algorithmen verbessern. Die Prognosegüte eines Modells wird, wie oben beschrieben, mit den Testdaten beurteilt. Hierbei werden anhand der Eingangsgrößen der Testdaten die zu erwartenden Ausgangsgrößen (in diesem Fall FeMo, FeSi, FeV …) prognostiziert. Anschließend wird überprüft, wie gut die Prognosen mit den real gemessenen Werten der Testdaten übereinstimmen (Messung vs. Prognose).

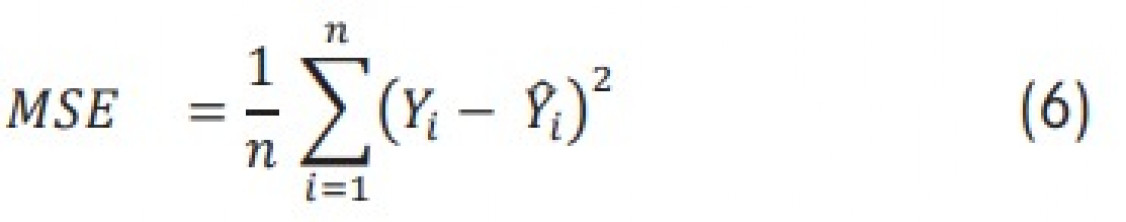

Zur Begutachtung dieser Prognosegüte bei Regressionsmodellen gibt es unterschiedliche Indikatoren, wie z.B.: Mittlere quadratische Abweichung (MSE):

Wurzel der mittleren quadratischen Abweichung (RMSE):

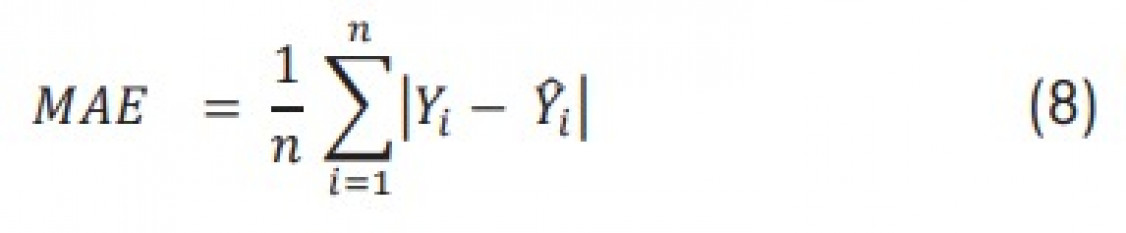

Mittlerer absoluter Fehler (MAE):

n: Anzahl der Datenwerte,

Yi: gemessener Wert

Ȳi: Prognosewert des Modells

Zusätzlich bietet sich die Gegenüberstellung von Messung und Prognose in einem einfachen X-Y-Koordinatensystem an.

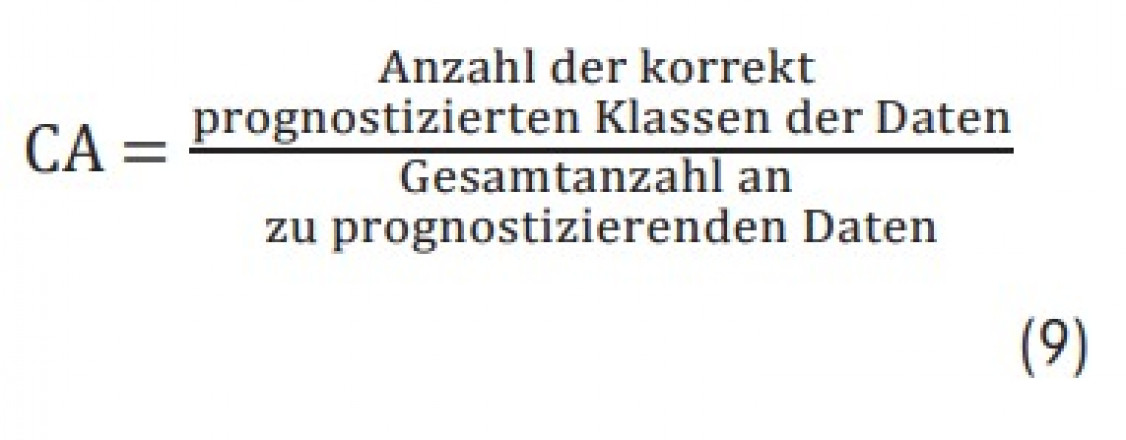

Handelt es sich um ein Klassifikationsproblem, gibt es Indikatoren wie z.B. die Konfusionsmatrix, die die Anzahl bzw. den Anteil der korrekt oder inkorrekt vorhergesagten Datenpaare und der tatsächlichen Klasse angibt. Auf diese Weise kann schnell festgestellt werden, welche Klassen das Modell gut prognostizieren kann und welche nicht. Zusätzlich gibt es noch weitere Indikatoren bei der Beurteilung der Prognose eines Klassifikationsmodells (Precision, F1, Recall …), von denen hier die „Classification Accuracy“ (CA) der einzelnen Modelle berücksichtigt werden soll:

Bei diesem Indikator werden die Anzahl der korrekt prognostizierten Klassen der Daten und die Gesamtanzahl an Daten ins Verhältnis gesetzt; ein Wert von 1 bzw. 100 % impliziert daher ein absolut perfektes Prognosemodell.

Ergebnisdiskussion

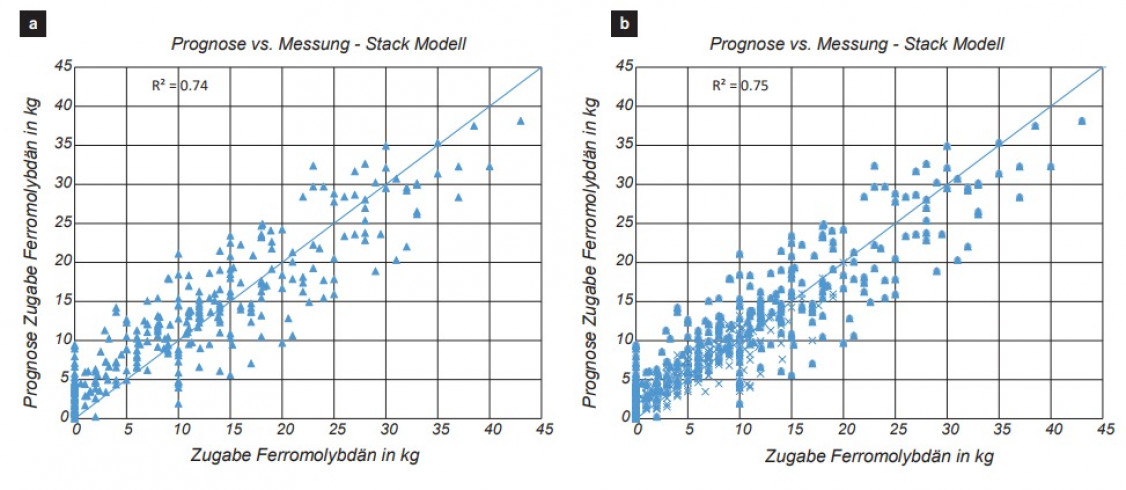

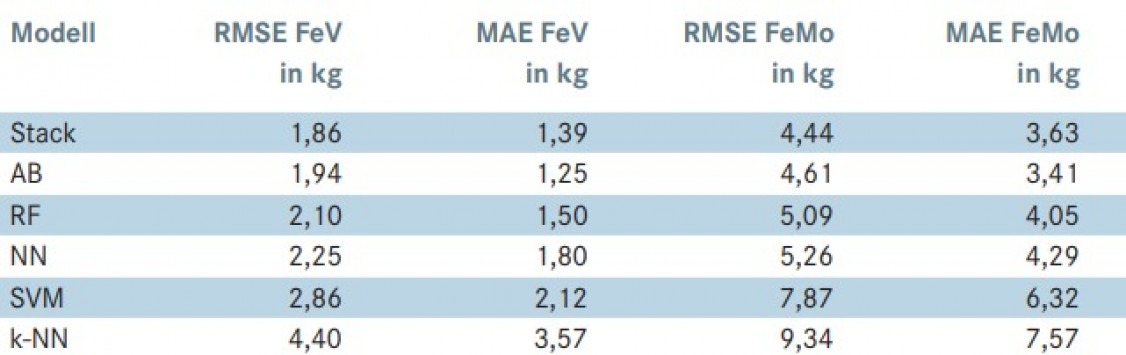

Bild 8 zeigt exemplarisch die Ergebnisse der Prognose (Input Testdaten) des Stack-Modells in Bezug auf die FeV- und FeMo-Zugabe sowie die Testdaten. In diesem Beispiel weisen die Machine-Learning-Algorithmen AdaBoost-Regression, Random-Forest-Regression sowie eine Kombination aus allen Modellen (Stack) den geringsten Prognosefehler auf. Anhand der Eingangsgrößen können mithilfe des Stack-Modells für die Testdaten die zu erwartende Menge Ferrovanadium auf ca. ± 2 kg (RMSE) und die des Ferromolybdäns auf ca. ± 4 kg (RMSE) prognostiziertwerden (Tabelle 4).

Der größte absolute Fehler des Stack-Modells liegt bezüglich FeV bei 7 kg und bezüglich FeMo bei 11 kg. Die Support-Vector-Machines und k-Nearest-Neighbor-Modelle weisen deutlich größere Prognosefehler auf, sie scheinen sich nicht für die (Regressions-)Modellierung dieser Daten zu eignen. Diese Algorithmen sind eher für Klassifikation anstatt Regression ausgelegt. Für die Anwendung dieser Modelle in der Fertigung bietet sich aus einer praxisorientieren Sicht die Umwandlung des Regressionsmodells in ein Klassifikationsmodell an.

Hierzu werden die Zugabemengen in Klassen eingeteilt. Als Beispiel dient erneut das Ferrovanadium:

> Klasse 1: geringe Zugabe (0 - 5 kg),

> Klasse 2: mittlere Zugabe (5 - 10 kg),

> Klasse 3: hohe Zugabe (über 10 kg)

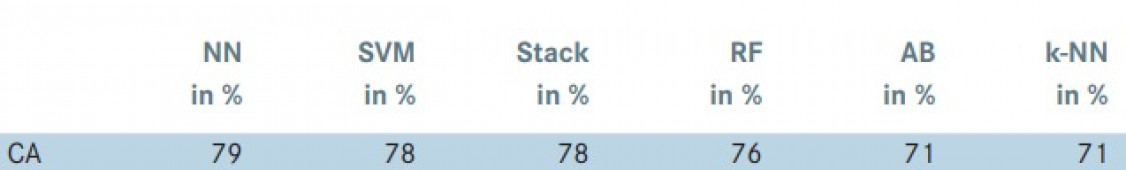

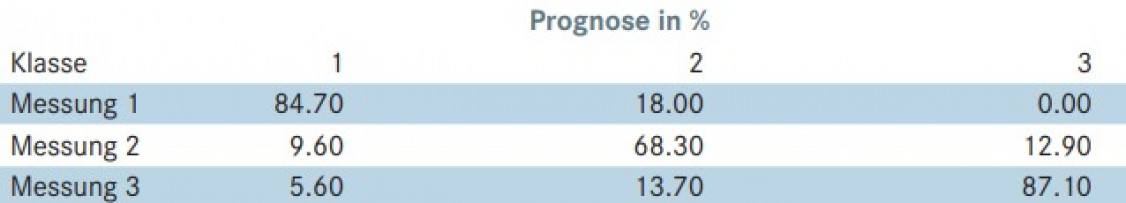

Die Inputdaten werden mithilfe von „Entropie-und MDL-Diskretisierung“ in Klassen eingeteilt. In Tabelle 5 sind die Ergebnisse der Klassifikation (Classification Accuracy) der unterschiedlichen Algorithmen bzgl. Ferrovanadium-Zugabe dargestellt. Tabelle 6 zeigt das detaillierte Ergebnis der Prognose der neuronalen Netze.

Während bei der Regression die neuronalen Netze bezüglich der Prognosegüte hinter Algorithmen wie z.B. Random Forest liegen, zeigen sie bei der Klassifikation die besten Gesamtergebnisse (79 % Classification Accuracy). Die Klassen 1 (FeV-Zugabe 0 - 5 kg) und 3 (FeVZugabe 10 - 15 kg) können durch neuronale Netze mit ca. 85 % bzw. 87 % Genauigkeit prognostiziert werden, Klasse 2 (FeV-Zugabe 5 - 10 kg) hingegen nur mit knapp 68 %.

Fazit

Es wurde eine innovative Methode vorgestellt, die mithilfe von datenbasierten Prognosemodellen sowie linearer Optimierung die Auswahl der Gattierung und das Schmelzen von Metallen im Induktionsofen hinsichtlich Ressourcen- und Energieeffizienz optimiert. Dabei ergänzt das Maschinelle Lernen die rein monetäre Sicht der linearen Optimierung um metallurgisches Wissen.

Die Simplex-Methode als Algorithmus der linearen Optimierung liefert bei entsprechender Datengrundlage in nahezu Echtzeit ein optimiertes Ergebnis hinsichtlich der Kosten. Über die Oberfläche einer Web-Anwendung können Nutzer eine Vielzahl von Nebenbedingungen hinzufügen, ohne die Performance der Berechnungen zu beeinträchtigen. Die Schnelligkeit lässt sich auf die Neu-Implementierung des Algorithmus in der Programmiersprache C# zurückführen. Die Brauchbarkeit der Ergebnisse hängt jedoch stark von den übergebenen Daten ab. Repräsentieren diese das metallurgische Problem nicht ausreichend, ist das zurückgegebene Ergebnis nach dem Schmelzen nicht zwangsläufig die günstigste Option, sodass ein Nachjustieren mit in der Regel teuren Primärrohstoffen erforderlich wird. Daher ist das Zuführen metallurgischer Einflussparameter über ML-Modelle notwendig.

Die datengetriebenen Prozessmodelle zeigen erste vielversprechende Ergebnisse bzgl. der Prognosegüte bei der Modellierung des Schmelzprozesses im Induktionsofen; eine verbesserte Datenbasis kann hier in Zukunft helfen, noch genauere Prognosemodelle zu erstellen. Als Beispiel wurde gezeigt, wie anhand der verfügbaren Daten der Rohstoffe und den Prozessparametern des Induktionsofens sowie der gewünschten Ziel-Zusammensetzung die zu erwartende Menge an benötigten Ferrolegierungen vorausgesagt werden kann. Besonders die Methodik des „Stacking“ von unterschiedlichen ML-Algorithmen zeigte bei der Regression die besten Prognoseergebnisse. Betrachtet man die unterschiedlichen Algorithmen im Einzelnen, so weisen die Random-Forest-Entscheidungsbäume die besten Ergebnisse auf. Bei der Umwandlung des Modells in ein Klassifikationsmodell zeigen hingegen die neuronalen Netze die besten Ergebnisse. Je nach Art der zu untersuchenden Daten und der aus prozesstechnischer Sicht relevanten Größen sollte entweder ein Regressions- oder Klassifikationsmodell erstellt werden. Prinzipiell lässt sich die hier vorgestellte Methode auf jede Art von Gießprozess (Eisenguss, Aluminiumguss etc.) sowie gewünschte Zielgröße (z.B. Ausschussreduzierung, Energieoptimierung etc.) anwenden.

Grundlage ist eine fundierte Digitalisierung des Fertigungsprozesses, was in der aktuellen Gießereilandschaft wahrscheinlich die in Zukunft größte zu überwindende Hürde sein wird. Die Implementierung dieser modernen digitalen Technologien in den Fertigungsprozess ist daher kein einfaches Unterfangen. Oftmals werden zusätzliche Sensorik, IT-Systeme und zusätzliches Personal benötigt; einen „schnellen“ und sofort sichtbaren Effekt können solche Systeme nicht immer erzielen. Eine sinnvolle Implementierung und Abstimmung der einzelnen Systeme wird benötigt, was nur durch eine Verfügbarkeit von Prozessdaten und deren sorgfältiger Auswahl erreichbar ist. Ist dies aber einmal geschafft, werden diese Methoden dabei helfen, die Wettbewerbsfähigkeit der deutschen Gießerei-Industrie auch in Zukunft zu erhalten und in einiger Zeit einen wichtigen Beitrag zur ressourcen- und energieeffizienten Fertigung leisten.

Die vorgestellten Arbeiten stammen aus dem Projekt „Optimierung der Rohstoffproduktivität in der Gießerei- und Stahlindustrie aus Produkten der Recyclingwirtschaft durch Nutzung moderner mathematischer Verfahren, Vernetzung und Digitalisierung“ (OptiRoDig). Das vom Bundesministerium für Bildung und Forschung (BMBF) geförderte Vorhaben wurde im Rahmen des Förderaufrufs „Ressourceneffiziente Kreislaufwirtschaft – Innovative Produktkreisläufe (ReziProk)“ ins Leben gerufen.

In diesem Projekt sind die beiden Firmen Friedr. Lohmann GmbH und RHM Rohstoff-Handelsgesellschaft mbH involviert. An dieser Stelle möchten wir uns bei den Projektverantwortlichen beider Firmen bedanken; insbesondere bei Herrn Dipl.-Ing. Friedrich Lohmann-Voß und Christoph Jonas, M.Sc.

Weitere Informationen

Universität Duisburg-Essen

Mathematik für Ingenieure

Prof. Dr. rer. nat. Johannes Gottschling,

Annika Tonnius, M.Sc.

Forsthausweg 2

47057 Duisburg

E-Mail: johannes.gottschling@uni-due.de, annika.tonnius@uni-due.de

www.uni-due.de/mfi/

Hochschule für angewandte

Wissenschaften Kempten

Labor für Werkstofftechnik und

Betriebsfestigkeit

Prof. Dr.-Ing. Dierk Hartmann,

Tim Kaufmann, M.Sc.

Bahnhofstrasse 61

87435 Kempten

E-Mail: dierk.hartmann@hs-kempten.de, tim.kaufmann@hs-kempten.de

www.hs-kempten.de

Literatur

[1] The Arabian Journal for Science and Engineering 29 (2004), [Nr. 1B], pp. 65–81.

[2] Engineering Applications of Artificial Intelligence 21 (2008), [Nr. 7], pp. 1001–1012.

[3] International Journal of Advanced Manufacturing Technologies (2008), [Nr. 39], pp. 1111–1124.

[4] International Journal of Metallurgy 11 (2017), pp. 255–265.

[5] Tsoukalas, V. An adaptive neuro-fuzzy inference system (ANFIS) model for high pressure die casting. Proc. Inst. Mech. Eng. Part. B J. Eng. Manuf. 2011, 225, 2276–2286.

[6] Götz, Fuchslocher: „BMW setzt auf Data Analytics in der Leichtmetallgießerei“, unter: https://www.automotiveit.eu/ technology/bmw-setzt-auf-data-analyticsin-der-leichtmetallgiesserei-215.html (abgerufen am 20.02.2021).

[7] GIESSEREI PRAXIS (2018), [Nr. 12], pp. 9–15.

[8] Management Science 35 (1989), [Nr.3], pp. 367-371.

[9] Environmental Science & Technology 51 (2017), [Nr. 22], pp. 13086-13094.

[10] GIESSEREI PRAXIS (2018), [Nr. 10], pp. 11–17, 2018.

[11] Hochstättler, W.: Lineare Optimierung, Berlin: Springer Spektrum, 2017.

[12] Raschka, S., Mirjalili, V.: Machine Learning mit Python und Scikit-Learn und TensorFlow: Das umfassende Praxis-Handbuch für Data Science, Predictive Analytics und Deep Learning. MITP-Verlags GmbH & Co. KG, 13. Dezember 2017, ISBN 978-3-95845-735-5.

[13] Usama M. Fayyad, Keki B. Irani: Multi-interval discretization of continuousvalued attributes for classification learning. In: Thirteenth International Joint Conference on Artificial Intelligence, 1022-1027, 1993.

Schlagworte

AluminiumAutomatisierungBetriebsfestigkeitCastingDigitalisierungDruckgussEisenEisengussEnergieeffizienzFertigungForschungGussGusseisenGussfehlerLieferketteMesseModellierungProduktionProzesskontrolleRecyclingSchmelzenSimulationSoftwareStahlStahlherstellungStahlindustrieVerlagWerkstoffeWerkstofftechnik